Si alguien dice las palabras “Windows”, “Apple”, “iOS” o “Android”, rápidamente las personas relacionan los términos con el mundo de las computadoras y los dispositivos móviles. Pero si se nombra a “Linux” muy pocos usuarios saben de lo que se está hablando y frecuentemente hay confusiones porque algunos se refieren más específicamente a “GNU/Linux”.

En este post vamos a desenredar esta diferencia y a repensar la filosofía que hay detrás de esto.

¿Qué es un sistema operativo?

Antes de ingresar en las comparaciones entre GNU/Linux y Linux, es fundamental entender qué es un sistema operativo (OS, por sus siglas en inglés). Supongamos que una computadora es un cuerpo. El sistema operativo sería las funciones neuronales que hacen funcionar a cada parte del organismo y también desde donde se desarrollan los pensamientos. Es el software que gestiona el hardware. En definitiva, el OS permite ejecutar programas y proporciona una interfaz para que los usuarios interactúen con la máquina.

Kernel: el centro del Sistema Operativo

Un componente clave de cualquier sistema operativo es su núcleo, también llamado “kernel”. Con la analogía anterior, esta parte sería lo que surge del cerebro, tanto lo voluntario como lo involuntario: el latido del corazón, respirar, mover las extremidades y pensar, entre cientos de cosas. O sea, en el plano de los sistemas es el encargado de asignar recursos, gestionar procesos y comunicarse con el hardware.

Qué es Linux

En este sentido, Linux es el núcleo de un sistema operativo, y fue desarrollado por el informático finlandés Linus Torvalds en 1991. Es un software libre, lo que significa que su código fuente está disponible para que cualquiera pueda examinarlo, modificarlo y distribuirlo. Esta libertad ha sido fundamental para una comunidad global de programadores que contribuyó a su mejora constante.

Qué es GNU

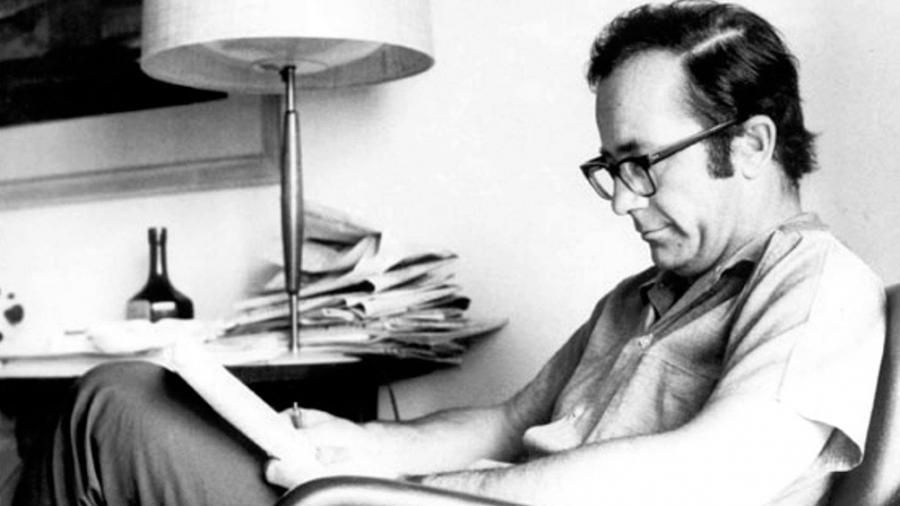

Por otro lado, GNU es un juego de palabra que significa GNU’s Not Unix (un OS de código cerrado) es un proyecto iniciado por el informático estadounidense Richard Stallman con el objetivo de crear un sistema operativo completamente libre.

El desarrollador comenzó este trabajo a principios de la década del ´80 como respuesta a los “sistemas privativos” que no permitían reescrituras en los códigos sin permisos de propiedad intelectual y licencias de uso.

En esta búsqueda, GNU delineó una gran cantidad de herramientas y utilidades fundamentales para un sistema operativo, como compiladores, editores de texto, shells y bibliotecas. Sin embargo nunca tuvo un kernel con la capacidad de potenciar todo el desarrollo.

La unión hace la fuerza

La historia en esta parte se transformó en algo previsible. Aunque Linux y GNU fueron proyectos independientes, se complementaron a la perfección. El núcleo de Linux, con su eficiencia y estabilidad, se combinó con las herramientas y utilidades de GNU para formar un sistema operativo completo y funcional. Por esta razón, muchos prefieren utilizar el término “GNU/Linux” para referirse al combo completo, especialmente Richard Stallman y sus seguidores. Linus Torvalds, sin embargo, nunca participó de la discusión.

Es por este motivo que hay personas que llaman a este OS “Linux”, mientras que otras prefieren “GNU/Linux”. Linux tiene como mascota y logo a un pingüino (llamado “Tux”). GNU, por su parte, se identifica con un Ñu, un antílope africano.

¿Android usa Linux?

El sistema operativo más popular en teléfonos móviles y tablets del mundo es Android y éste utiliza el núcleo de Linux como base. Esto le proporciona una sólida plataforma para gestionar tareas esenciales como la administración de memoria, procesos e interconectividad entre diferentes dispositivos. También contribuye a generar una comunidad de desarrolladores de aplicaciones, lo que potencia su usabilidad y popularidad.

Algunas de las distribuciones más populares de Linux para computadoras:

- Ubuntu

- Linux Mint

- Debian

- Fedora

- CentOS

- Arch Linux

- Manjaro

- OpenSUSE

- Red Hat

Gracias por llegar hasta acá. Mi nombre es Ariel Diez y si te gustó este contenido te invito a leer estos artículos de #HuellasTechs:

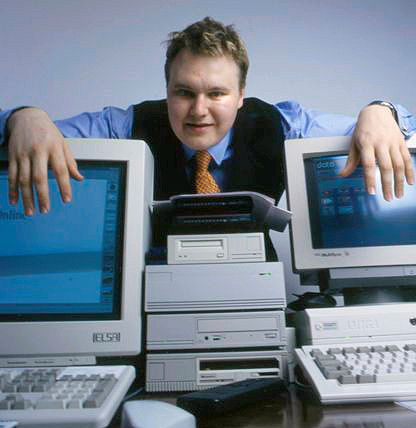

Kim Dotcom: hacker, magnate y villano de internet — #HuellasTechs

Rodolfo Walsh: ¿El primer hacker argentino? — #HuellasTechs

Volt Typhoon: el grupo de hackers por el que China y Estados Unidos se pelean — #HuellasTechs

Stuxnet: el virus informático que redefinió la guerra cibernética — #HuellasTechs